Оригинал: How I Built a Self-Hosted AI Server in 5 Minutes (And You Can Too!)

Перевод для канала Мы ж программист

1. Почему я отказался от нескольких ИИ-сервисов

Несколько месяцев назад мой рабочий процесс выглядел следующим образом:

- Открыть ChatGPT → дождаться загрузки → ввести запрос.

- Переключиться на Claude → снова войти в систему → составить другой запрос.

- Повторить для Gemini, DeepSeek и любого нового клона GPT, который я тестировал на той неделе.

К тому времени, когда я получал связный ответ, кофе уже остыл, а вдохновение исчезло. Кроме того, каждый сервис стоил примерно 18 долларов в месяц, так что я тратил кучу денег. Хуже всего было то, что я понятия не имел, где хранятся мои данные и как они используются. Тогда я спросил себя:

«А что, если я смогу разместить все свои любимые модели ИИ на одном локальном сервере, платить только за то, что использую, и хранить свои данные у себя?»

Спойлер: это удивительно просто.

2. Ваш ИИ-дэшборд всё-в-одном

Представляем Open WebUI + Ollama — комбинацию, которая превращает ваш ноутбук (или облачную виртуальную машину) в мощный инструмент искусственного интеллекта. Вот что вы получаете:

- Единый интерфейс для всех ваших любимых моделей.

- Оплата по факту использования — больше никаких фиксированных ежемесячных платежей.

- Суверенитет данных — выбирайте поставщиков API по политике конфиденциальности и региону.

Совет из реальной жизни: теперь я одним щелчком мыши переключаюсь с GPT-4o на более компактную и дешевую модель в середине сеанса — идеально подходит для быстрых последующих действий или мозгового штурма.

3. Как сократить расходы, но сохранить мощность

Подписки ушли в прошлое, на смену им пришла оплата по факту использования. Представьте себе следующую ситуацию:

- Вы отправляете 1000 запросов по 0,01 доллара за каждый — это всего 10 долларов.

- Нет активной подписки = нулевые расходы, когда вы не проводите эксперименты.

Добавьте LiteLLM, и вы сможете:

- Установить жесткие ограничения на расходы, чтобы ваши дети не набежали огромный счет, экспериментируя с генерацией изображений.

- Назначить уровни пользователей, предоставляя новичкам доступ к легким моделям, а опытным пользователям — к тяжелым.

Ваш кошелек — и ваше душевное равновесие — будут вам благодарны.

4. Более чем текст: используйте все возможности

Зачем ограничиваться чатом? Эта настройка открывает следующие возможности:

- Создание изображений: создавайте визуальные элементы с помощью движков преобразования текста в изображения прямо из вашего локального пользовательского интерфейса.

- Голосовые функции: играйте с преобразованием речи в текст и текста в речь без внешних плагинов.

- Встроенный веб-поиск: получайте актуальную информацию, не отправляя запросы в крупные технологические компании.

- Офлайн-режим: нет интернета? Не проблема — вы все равно можете общаться с локальными моделями.

Это как швейцарский армейский нож для ИИ — все в одном месте.

5. Железная конфиденциальность: ваши данные, ваши правила

Устали гадать, куда попадают ваши данные? С собственным сервером вы сами решаете:

- Меняйте API на лету, если политика конфиденциальности провайдера вызывает подозрения.

- Географически маршрутизируйте трафик, чтобы данные оставались в утвержденных юрисдикциях.

- Устраните скрытые положения — ваши запросы остаются вашими, и точка.

Короче говоря: никаких подлых положений об использовании в исследовательских целях, никаких загадочных каналов передачи данных.

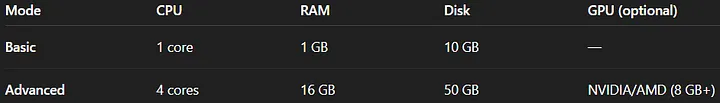

6. Проверка железа: удостоверьтесь, что вы готовы

Docker — единственное необходимое условие. Есть GPU? Еще лучше — для больших локальных моделей поддержка CUDA/OpenCL — это мечта.

7. Защита: лучшие практики безопасности

Собственный хостинг — это интересно, но безопасность превыше всего:

- VPN или Tailscale: обеспечьте безопасный туннель — никогда не открывайте порт 3000 для общего доступа.

- Правила брандмауэра: добавьте в белый список только свой IP-адрес или подсеть VPN.

- Обратный прокси: используйте Nginx или Traefik для HTTPS, ограничения скорости и SSO.

Эти шаги превратят ваш домашний сервер в крепость корпоративного уровня.

8. Многопользовательская магия: контроль доступа

У вас есть коллеги или члены семьи, которые будут пользоваться? Настройте:

- Роли администратора и пользователя: только доверенные учетные записи получают полные привилегии.

- Интеграция SSO: подключите GitHub, Google или ваш корпоративный IdP через прокси OAuth2.

- Разрешения на основе ролей: ограничьте доступ к моделям и функциям по группам.

Несколько кликов — и у вас есть безопасная общая площадка для работы с ИИ.

9. Сохраняйте динамику: мониторинг и масштабирование

Ничто так не убивает креативность, как задержки:

- docker stats: быстрая статистика использования ЦП/памяти/сети в вашем терминале.

- Prometheus + Grafana: легкие дашборды для визуализации трендов.

- Горизонтальное масштабирование: запустите несколько контейнеров за балансировщиком нагрузки.

Выявляйте узкие места на ранней стадии и добавляйте ресурсы именно там, где они нужны.

10. Станьте более эффективными: квантование моделей

Нет необходимости запускать 100-гигабайтную модель для каждой задачи:

- Квантованные форматы (GGUF, Q4_0) сокращают размер моделей до 75%.

- Развертывание на периферии: запускайте ИИ на ноутбуках, мини-ПК и даже Raspberry Pi.

- Конвертация в один клик: Ollama или оптимальный инструмент Hugging Face выполняют всю тяжелую работу.

Идеально подходит для офлайн-демонстраций или проектов IoT.

11. Защита от аварий: резервное копирование и восстановление

План на случай закона Мерфи:

docker run --rm --volumes-from open-webui \

-v $(pwd):/backup busybox \

tar czf /backup/owui-backup.tgz /app/backend/data- Регулярно создавайте моментальные снимки томов.

- Документируйте шаги по восстановлению, чтобы вы могли восстановить данные за считанные минуты.

- Храните конфигурации в Git — больше не нужно гадать: «Что я вводил в последний раз?».

12. Юридическая проверка: лицензирование и соответствие требованиям

Не дайте себя застать врасплох неожиданными положениями:

- Просмотрите условия использования API: обратите внимание на ограничения использования или положения об исследованиях.

- GDPR/CCPA: если вы храните пользовательские данные, убедитесь, что вы соблюдаете региональные законы о конфиденциальности.

- Локальные лицензии: для некоторых моделей требуются коммерческие лицензии для производства.

Быстрая юридическая проверка избавит вас от головной боли (и штрафов) в будущем.

13. Быстрый старт: запуск за 5 минут

Готовы начать? Вставьте это:

docker run -d \

-p 3000:8080 \

-v ollama:/root/.ollama \

-v open-webui:/app/backend/data \

--name open-webui \

--restart always \

ghcr.io/open-webui/open-webui:ollama- Подождите несколько секунд.

- Перейдите на сайт

http://localhost:3000и создайте учетную запись администратора. - Вот и все — ваш самостоятельно размещенный сервер искусственного интеллекта готов к работе.

14. Совмещайте облачные модели

Локальные модели — это хорошо, но иногда облачные модели — это лучше:

- Перейдите в «Настройки» → «Подключения».

- Нажмите «+», вставьте эндпоинт API и ключ.

- Нажмите «Тест», чтобы подтвердить.

Теперь вы можете легко переключаться между локальными и удаленными моделями.

Готовы взять контроль в свои руки?

Попрощайтесь с усталостью от вкладок, скрытыми комиссиями и черными ящиками данных. Ваш самостоятельно размещенный сервер ИИ ждет вас — запустите его, экспериментируйте и делитесь своими успехами (или неудачами) в комментариях ниже. Давайте вместе построим будущее персонального ИИ!